Gin

gin框架路由详解

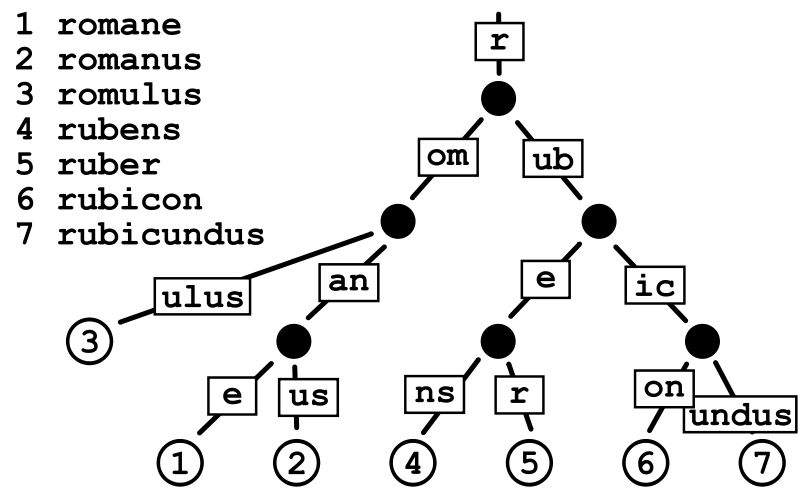

gin框架使用的是定制版本的httprouter,其路由的原理是大量使用公共前缀的树结构,它基本上是一个紧凑的Trie tree(或者只是Radix Tree)。具有公共前缀的节点也共享一个公共父节点。

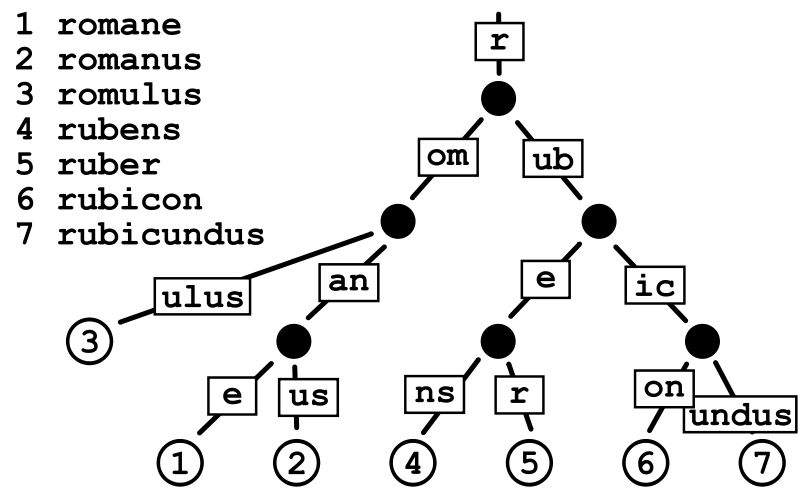

Radix Tree

基数树(Radix Tree)又称为PAT位树(Patricia Trie or crit bit tree),是一种更节省空间的前缀树(Trie Tree)。对于基数树的每个节点,如果该节点是唯一的子树的话,就和父节点合并。下图为一个基数树示例:

Radix Tree可以被认为是一棵简洁版的前缀树。我们注册路由的过程就是构造前缀树的过程,具有公共前缀的节点也共享一个公共父节点。假设我们现在注册有以下路由信息:

1

2

3

4

5

6

7

8

9

10

|

r := gin.Default()

r.GET("/", func1)

r.GET("/search/", func2)

r.GET("/support/", func3)

r.GET("/blog/", func4)

r.GET("/blog/:post/", func5)

r.GET("/about-us/", func6)

r.GET("/about-us/team/", func7)

r.GET("/contact/", func8)

|

那么我们会得到一个GET方法对应的路由树,具体结构如下:

1

2

3

4

5

6

7

8

9

10

11

|

Priority Path Handle

9 \ *<1>

3 ├s nil

2 |├earch\ *<2>

1 |└upport\ *<3>

2 ├blog\ *<4>

1 | └:post nil

1 | └\ *<5>

2 ├about-us\ *<6>

1 | └team\ *<7>

1 └contact\ *<8>

|

上面最右边那一列每个*<数字>表示Handle处理函数的内存地址(一个指针)。从根节点遍历到叶子节点我们就能得到完整的路由表。

例如:blog/:post其中:post只是实际文章名称的占位符(参数)。与hash-maps不同,这种树结构还允许我们使用像:post参数这种动态部分,因为我们实际上是根据路由模式进行匹配,而不仅仅是比较哈希值。

由于URL路径具有层次结构,并且只使用有限的一组字符(字节值),所以很可能有许多常见的前缀。这使我们可以很容易地将路由简化为更小的问题。此外,路由器为每种请求方法管理一棵单独的树。一方面,它比在每个节点中都保存一个method-> handle map更加节省空间,它还使我们甚至可以在开始在前缀树中查找之前大大减少路由问题。

为了获得更好的可伸缩性,每个树级别上的子节点都按Priority(优先级)排序,其中优先级(最左列)就是在子节点(子节点、子子节点等等)中注册的句柄的数量。这样做有两个好处:

- 首先优先匹配被大多数路由路径包含的节点。这样可以让尽可能多的路由快速被定位。

- 类似于成本补偿。最长的路径可以被优先匹配,补偿体现在最长的路径需要花费更长的时间来定位,如果最长路径的节点能被优先匹配(即每次拿子节点都命中),那么路由匹配所花的时间不一定比短路径的路由长。下面展示了节点(每个

-可以看做一个节点)匹配的路径:从左到右,从上到下。

1

2

3

4

5

6

7

|

├------------

├---------

├-----

├----

├--

├--

└-

|

路由树节点

路由树是由一个个节点构成的,gin框架路由树的节点由node结构体表示,它有以下字段:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

|

// tree.go

type node struct {

// 节点路径,比如上面的s,earch,和upport

path string

// 和children字段对应, 保存的是分裂的分支的第一个字符

// 例如search和support, 那么s节点的indices对应的"eu"

// 代表有两个分支, 分支的首字母分别是e和u

indices string

// 儿子节点

children []*node

// 处理函数链条(切片)

handlers HandlersChain

// 优先级,子节点、子子节点等注册的handler数量

priority uint32

// 节点类型,包括static, root, param, catchAll

// static: 静态节点(默认),比如上面的s,earch等节点

// root: 树的根节点

// catchAll: 有*匹配的节点

// param: 参数节点

nType nodeType

// 路径上最大参数个数

maxParams uint8

// 节点是否是参数节点,比如上面的:post

wildChild bool

// 完整路径

fullPath string

}

|

请求方法树

在gin的路由中,每一个HTTP Method(GET、POST、PUT、DELETE…)都对应了一棵 radix tree,我们注册路由的时候会调用下面的addRoute函数:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

|

// gin.go

func (engine *Engine) addRoute(method, path string, handlers HandlersChain) {

// liwenzhou.com...

// 获取请求方法对应的树

root := engine.trees.get(method)

if root == nil {

// 如果没有就创建一个

root = new(node)

root.fullPath = "/"

engine.trees = append(engine.trees, methodTree{method: method, root: root})

}

root.addRoute(path, handlers)

}

|

从上面的代码中我们可以看到在注册路由的时候都是先根据请求方法获取对应的树,也就是gin框架会为每一个请求方法创建一棵对应的树。只不过需要注意到一个细节是gin框架中保存请求方法对应树关系并不是使用的map而是使用的切片,engine.trees的类型是methodTrees,其定义如下:

1

2

3

4

5

6

|

type methodTree struct {

method string

root *node

}

type methodTrees []methodTree // slice

|

而获取请求方法对应树的get方法定义如下:

1

2

3

4

5

6

7

8

|

func (trees methodTrees) get(method string) *node {

for _, tree := range trees {

if tree.method == method {

return tree.root

}

}

return nil

}

|

为什么使用切片而不是map来存储请求方法->树的结构呢?我猜是出于节省内存的考虑吧,毕竟HTTP请求方法的数量是固定的,而且常用的就那几种,所以即使使用切片存储查询起来效率也足够了。顺着这个思路,我们可以看一下gin框架中engine的初始化方法中,确实对tress字段做了一次内存申请:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

|

func New() *Engine {

debugPrintWARNINGNew()

engine := &Engine{

RouterGroup: RouterGroup{

Handlers: nil,

basePath: "/",

root: true,

},

// liwenzhou.com ...

// 初始化容量为9的切片(HTTP1.1请求方法共9种)

trees: make(methodTrees, 0, 9),

// liwenzhou.com...

}

engine.RouterGroup.engine = engine

engine.pool.New = func() interface{} {

return engine.allocateContext()

}

return engine

}

|

注册路由

注册路由的逻辑主要有addRoute函数和insertChild方法。

addRoute

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

117

118

119

120

121

122

123

124

125

126

127

128

129

130

131

132

133

134

135

136

137

138

139

140

141

142

143

|

// tree.go

// addRoute 将具有给定句柄的节点添加到路径中。

// 不是并发安全的

func (n *node) addRoute(path string, handlers HandlersChain) {

fullPath := path

n.priority++

numParams := countParams(path) // 数一下参数个数

// 空树就直接插入当前节点

if len(n.path) == 0 && len(n.children) == 0 {

n.insertChild(numParams, path, fullPath, handlers)

n.nType = root

return

}

parentFullPathIndex := 0

walk:

for {

// 更新当前节点的最大参数个数

if numParams > n.maxParams {

n.maxParams = numParams

}

// 找到最长的通用前缀

// 这也意味着公共前缀不包含“:”"或“*” /

// 因为现有键不能包含这些字符。

i := longestCommonPrefix(path, n.path)

// 分裂边缘(此处分裂的是当前树节点)

// 例如一开始path是search,新加入support,s是他们通用的最长前缀部分

// 那么会将s拿出来作为parent节点,增加earch和upport作为child节点

if i < len(n.path) {

child := node{

path: n.path[i:], // 公共前缀后的部分作为子节点

wildChild: n.wildChild,

indices: n.indices,

children: n.children,

handlers: n.handlers,

priority: n.priority - 1, //子节点优先级-1

fullPath: n.fullPath,

}

// Update maxParams (max of all children)

for _, v := range child.children {

if v.maxParams > child.maxParams {

child.maxParams = v.maxParams

}

}

n.children = []*node{&child}

// []byte for proper unicode char conversion, see #65

n.indices = string([]byte{n.path[i]})

n.path = path[:i]

n.handlers = nil

n.wildChild = false

n.fullPath = fullPath[:parentFullPathIndex+i]

}

// 将新来的节点插入新的parent节点作为子节点

if i < len(path) {

path = path[i:]

if n.wildChild { // 如果是参数节点

parentFullPathIndex += len(n.path)

n = n.children[0]

n.priority++

// Update maxParams of the child node

if numParams > n.maxParams {

n.maxParams = numParams

}

numParams--

// 检查通配符是否匹配

if len(path) >= len(n.path) && n.path == path[:len(n.path)] {

// 检查更长的通配符, 例如 :name and :names

if len(n.path) >= len(path) || path[len(n.path)] == '/' {

continue walk

}

}

pathSeg := path

if n.nType != catchAll {

pathSeg = strings.SplitN(path, "/", 2)[0]

}

prefix := fullPath[:strings.Index(fullPath, pathSeg)] + n.path

panic("'" + pathSeg +

"' in new path '" + fullPath +

"' conflicts with existing wildcard '" + n.path +

"' in existing prefix '" + prefix +

"'")

}

// 取path首字母,用来与indices做比较

c := path[0]

// 处理参数后加斜线情况

if n.nType == param && c == '/' && len(n.children) == 1 {

parentFullPathIndex += len(n.path)

n = n.children[0]

n.priority++

continue walk

}

// 检查路path下一个字节的子节点是否存在

// 比如s的子节点现在是earch和upport,indices为eu

// 如果新加一个路由为super,那么就是和upport有匹配的部分u,将继续分列现在的upport节点

for i, max := 0, len(n.indices); i < max; i++ {

if c == n.indices[i] {

parentFullPathIndex += len(n.path)

i = n.incrementChildPrio(i)

n = n.children[i]

continue walk

}

}

// 否则就插入

if c != ':' && c != '*' {

// []byte for proper unicode char conversion, see #65

// 注意这里是直接拼接第一个字符到n.indices

n.indices += string([]byte{c})

child := &node{

maxParams: numParams,

fullPath: fullPath,

}

// 追加子节点

n.children = append(n.children, child)

n.incrementChildPrio(len(n.indices) - 1)

n = child

}

n.insertChild(numParams, path, fullPath, handlers)

return

}

// 已经注册过的节点

if n.handlers != nil {

panic("handlers are already registered for path '" + fullPath + "'")

}

n.handlers = handlers

return

}

}

|

其实上面的代码很好理解,大家可以参照动画尝试将以下情形代入上面的代码逻辑,体味整个路由树构造的详细过程:

- 第一次注册路由,例如注册search

- 继续注册一条没有公共前缀的路由,例如blog

- 注册一条与先前注册的路由有公共前缀的路由,例如support

insertChild

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

117

118

119

|

// tree.go

func (n *node) insertChild(numParams uint8, path string, fullPath string, handlers HandlersChain) {

// 找到所有的参数

for numParams > 0 {

// 查找前缀直到第一个通配符

wildcard, i, valid := findWildcard(path)

if i < 0 { // 没有发现通配符

break

}

// 通配符的名称必须包含':' 和 '*'

if !valid {

panic("only one wildcard per path segment is allowed, has: '" +

wildcard + "' in path '" + fullPath + "'")

}

// 检查通配符是否有名称

if len(wildcard) < 2 {

panic("wildcards must be named with a non-empty name in path '" + fullPath + "'")

}

// 检查这个节点是否有已经存在的子节点

// 如果我们在这里插入通配符,这些子节点将无法访问

if len(n.children) > 0 {

panic("wildcard segment '" + wildcard +

"' conflicts with existing children in path '" + fullPath + "'")

}

if wildcard[0] == ':' { // param

if i > 0 {

// 在当前通配符之前插入前缀

n.path = path[:i]

path = path[i:]

}

n.wildChild = true

child := &node{

nType: param,

path: wildcard,

maxParams: numParams,

fullPath: fullPath,

}

n.children = []*node{child}

n = child

n.priority++

numParams--

// 如果路径没有以通配符结束

// 那么将有另一个以'/'开始的非通配符子路径。

if len(wildcard) < len(path) {

path = path[len(wildcard):]

child := &node{

maxParams: numParams,

priority: 1,

fullPath: fullPath,

}

n.children = []*node{child}

n = child // 继续下一轮循环

continue

}

// 否则我们就完成了。将处理函数插入新叶子中

n.handlers = handlers

return

}

// catchAll

if i+len(wildcard) != len(path) || numParams > 1 {

panic("catch-all routes are only allowed at the end of the path in path '" + fullPath + "'")

}

if len(n.path) > 0 && n.path[len(n.path)-1] == '/' {

panic("catch-all conflicts with existing handle for the path segment root in path '" + fullPath + "'")

}

// currently fixed width 1 for '/'

i--

if path[i] != '/' {

panic("no / before catch-all in path '" + fullPath + "'")

}

n.path = path[:i]

// 第一个节点:路径为空的catchAll节点

child := &node{

wildChild: true,

nType: catchAll,

maxParams: 1,

fullPath: fullPath,

}

// 更新父节点的maxParams

if n.maxParams < 1 {

n.maxParams = 1

}

n.children = []*node{child}

n.indices = string('/')

n = child

n.priority++

// 第二个节点:保存变量的节点

child = &node{

path: path[i:],

nType: catchAll,

maxParams: 1,

handlers: handlers,

priority: 1,

fullPath: fullPath,

}

n.children = []*node{child}

return

}

// 如果没有找到通配符,只需插入路径和句柄

n.path = path

n.handlers = handlers

n.fullPath = fullPath

}

|

insertChild函数是根据path本身进行分割,将/分开的部分分别作为节点保存,形成一棵树结构。参数匹配中的:和*的区别是,前者是匹配一个字段而后者是匹配后面所有的路径。

路由匹配

我们先来看gin框架处理请求的入口函数ServeHTTP:

1

2

3

4

5

6

7

8

9

10

11

12

13

|

// gin.go

func (engine *Engine) ServeHTTP(w http.ResponseWriter, req *http.Request) {

// 这里使用了对象池

c := engine.pool.Get().(*Context)

// 这里有一个细节就是Get对象后做初始化

c.writermem.reset(w)

c.Request = req

c.reset()

engine.handleHTTPRequest(c) // 我们要找的处理HTTP请求的函数

engine.pool.Put(c) // 处理完请求后将对象放回池子

}

|

函数很长,这里省略了部分代码,只保留相关逻辑代码:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

|

// gin.go

func (engine *Engine) handleHTTPRequest(c *Context) {

// liwenzhou.com...

// 根据请求方法找到对应的路由树

t := engine.trees

for i, tl := 0, len(t); i < tl; i++ {

if t[i].method != httpMethod {

continue

}

root := t[i].root

// 在路由树中根据path查找

value := root.getValue(rPath, c.Params, unescape)

if value.handlers != nil {

c.handlers = value.handlers

c.Params = value.params

c.fullPath = value.fullPath

c.Next() // 执行函数链条

c.writermem.WriteHeaderNow()

return

}

// liwenzhou.com...

c.handlers = engine.allNoRoute

serveError(c, http.StatusNotFound, default404Body)

}

|

路由匹配是由节点的 getValue方法实现的。getValue根据给定的路径(键)返回nodeValue值,保存注册的处理函数和匹配到的路径参数数据。

如果找不到任何处理函数,则会尝试TSR(尾随斜杠重定向)。

代码虽然很长,但还算比较工整。大家可以借助注释看一下路由查找及参数匹配的逻辑。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

117

118

119

120

121

122

123

124

125

126

127

128

129

130

131

132

133

134

135

136

137

138

139

140

141

142

143

144

145

146

147

148

149

150

|

// tree.go

type nodeValue struct {

handlers HandlersChain

params Params // []Param

tsr bool

fullPath string

}

// liwenzhou.com...

func (n *node) getValue(path string, po Params, unescape bool) (value nodeValue) {

value.params = po

walk: // Outer loop for walking the tree

for {

prefix := n.path

if path == prefix {

// 我们应该已经到达包含处理函数的节点。

// 检查该节点是否注册有处理函数

if value.handlers = n.handlers; value.handlers != nil {

value.fullPath = n.fullPath

return

}

if path == "/" && n.wildChild && n.nType != root {

value.tsr = true

return

}

// 没有找到处理函数 检查这个路径末尾+/ 是否存在注册函数

indices := n.indices

for i, max := 0, len(indices); i < max; i++ {

if indices[i] == '/' {

n = n.children[i]

value.tsr = (len(n.path) == 1 && n.handlers != nil) ||

(n.nType == catchAll && n.children[0].handlers != nil)

return

}

}

return

}

if len(path) > len(prefix) && path[:len(prefix)] == prefix {

path = path[len(prefix):]

// 如果该节点没有通配符(param或catchAll)子节点

// 我们可以继续查找下一个子节点

if !n.wildChild {

c := path[0]

indices := n.indices

for i, max := 0, len(indices); i < max; i++ {

if c == indices[i] {

n = n.children[i] // 遍历树

continue walk

}

}

// 没找到

// 如果存在一个相同的URL但没有末尾/的叶子节点

// 我们可以建议重定向到那里

value.tsr = path == "/" && n.handlers != nil

return

}

// 根据节点类型处理通配符子节点

n = n.children[0]

switch n.nType {

case param:

// find param end (either '/' or path end)

end := 0

for end < len(path) && path[end] != '/' {

end++

}

// 保存通配符的值

if cap(value.params) < int(n.maxParams) {

value.params = make(Params, 0, n.maxParams)

}

i := len(value.params)

value.params = value.params[:i+1] // 在预先分配的容量内扩展slice

value.params[i].Key = n.path[1:]

val := path[:end]

if unescape {

var err error

if value.params[i].Value, err = url.QueryUnescape(val); err != nil {

value.params[i].Value = val // fallback, in case of error

}

} else {

value.params[i].Value = val

}

// 继续向下查询

if end < len(path) {

if len(n.children) > 0 {

path = path[end:]

n = n.children[0]

continue walk

}

// ... but we can't

value.tsr = len(path) == end+1

return

}

if value.handlers = n.handlers; value.handlers != nil {

value.fullPath = n.fullPath

return

}

if len(n.children) == 1 {

// 没有找到处理函数. 检查此路径末尾加/的路由是否存在注册函数

// 用于 TSR 推荐

n = n.children[0]

value.tsr = n.path == "/" && n.handlers != nil

}

return

case catchAll:

// 保存通配符的值

if cap(value.params) < int(n.maxParams) {

value.params = make(Params, 0, n.maxParams)

}

i := len(value.params)

value.params = value.params[:i+1] // 在预先分配的容量内扩展slice

value.params[i].Key = n.path[2:]

if unescape {

var err error

if value.params[i].Value, err = url.QueryUnescape(path); err != nil {

value.params[i].Value = path // fallback, in case of error

}

} else {

value.params[i].Value = path

}

value.handlers = n.handlers

value.fullPath = n.fullPath

return

default:

panic("invalid node type")

}

}

// 找不到,如果存在一个在当前路径最后添加/的路由

// 我们会建议重定向到那里

value.tsr = (path == "/") ||

(len(prefix) == len(path)+1 && prefix[len(path)] == '/' &&

path == prefix[:len(prefix)-1] && n.handlers != nil)

return

}

}

|

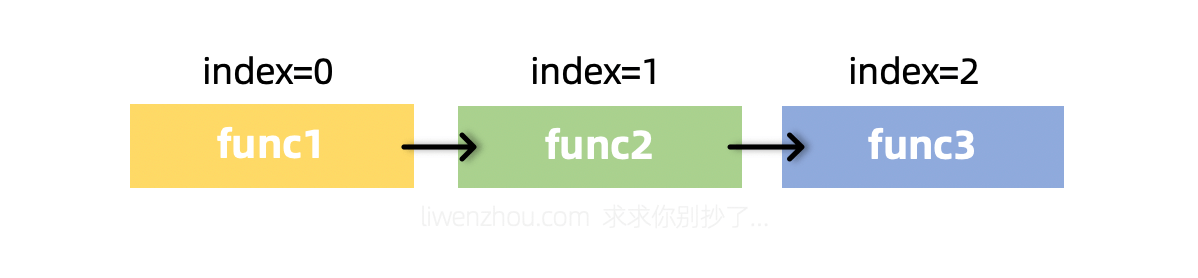

gin框架中间件详解

gin框架涉及中间件相关有4个常用的方法,它们分别是c.Next()、c.Abort()、c.Set()、c.Get()。

中间件的注册

gin框架中的中间件设计很巧妙,我们可以首先从我们最常用的r := gin.Default()的Default函数开始看,它内部构造一个新的engine之后就通过Use()函数注册了Logger中间件和Recovery中间件:

1

2

3

4

5

6

|

func Default() *Engine {

debugPrintWARNINGDefault()

engine := New()

engine.Use(Logger(), Recovery()) // 默认注册的两个中间件

return engine

}

|

继续往下查看一下Use()函数的代码:

1

2

3

4

5

6

|

func (engine *Engine) Use(middleware ...HandlerFunc) IRoutes {

engine.RouterGroup.Use(middleware...) // 实际上还是调用的RouterGroup的Use函数

engine.rebuild404Handlers()

engine.rebuild405Handlers()

return engine

}

|

从下方的代码可以看出,注册中间件其实就是将中间件函数追加到group.Handlers中:

1

2

3

4

|

func (group *RouterGroup) Use(middleware ...HandlerFunc) IRoutes {

group.Handlers = append(group.Handlers, middleware...)

return group.returnObj()

}

|

而我们注册路由时会将对应路由的函数和之前的中间件函数结合到一起:

1

2

3

4

5

6

|

func (group *RouterGroup) handle(httpMethod, relativePath string, handlers HandlersChain) IRoutes {

absolutePath := group.calculateAbsolutePath(relativePath)

handlers = group.combineHandlers(handlers) // 将处理请求的函数与中间件函数结合

group.engine.addRoute(httpMethod, absolutePath, handlers)

return group.returnObj()

}

|

其中结合操作的函数内容如下,注意观察这里是如何实现拼接两个切片得到一个新切片的。

1

2

3

4

5

6

7

8

9

10

11

12

|

const abortIndex int8 = math.MaxInt8 / 2

func (group *RouterGroup) combineHandlers(handlers HandlersChain) HandlersChain {

finalSize := len(group.Handlers) + len(handlers)

if finalSize >= int(abortIndex) { // 这里有一个最大限制

panic("too many handlers")

}

mergedHandlers := make(HandlersChain, finalSize)

copy(mergedHandlers, group.Handlers)

copy(mergedHandlers[len(group.Handlers):], handlers)

return mergedHandlers

}

|

也就是说,我们会将一个路由的中间件函数和处理函数结合到一起组成一条处理函数链条HandlersChain,而它本质上就是一个由HandlerFunc组成的切片:

1

|

type HandlersChain []HandlerFunc

|

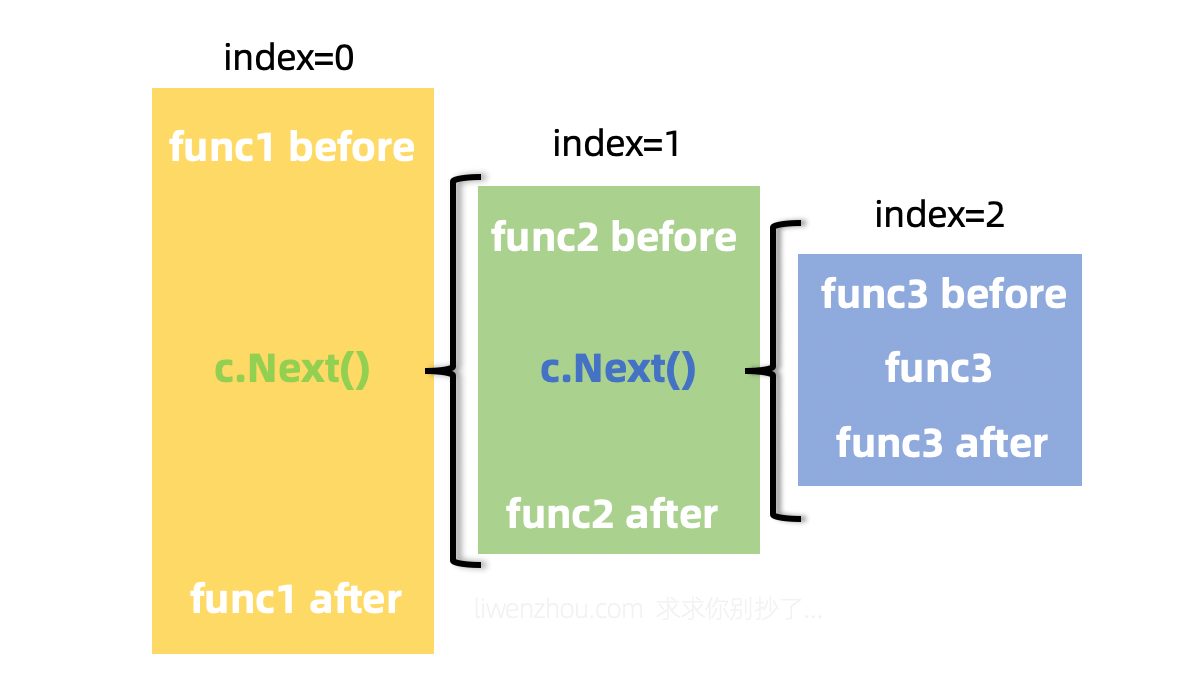

中间件的执行

我们在上面路由匹配的时候见过如下逻辑:

1

2

3

4

5

6

7

8

9

|

value := root.getValue(rPath, c.Params, unescape)

if value.handlers != nil {

c.handlers = value.handlers

c.Params = value.params

c.fullPath = value.fullPath

c.Next() // 执行函数链条

c.writermem.WriteHeaderNow()

return

}

|

其中c.Next()就是很关键的一步,它的代码很简单:

1

2

3

4

5

6

7

|

func (c *Context) Next() {

c.index++

for c.index < int8(len(c.handlers)) {

c.handlers[c.index](c)

c.index++

}

}

|

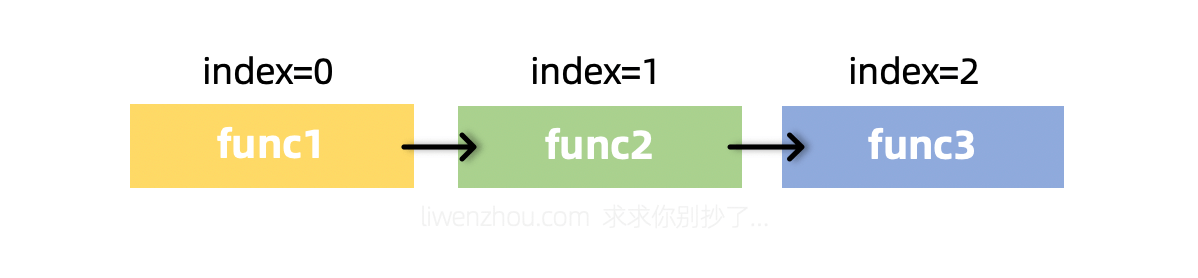

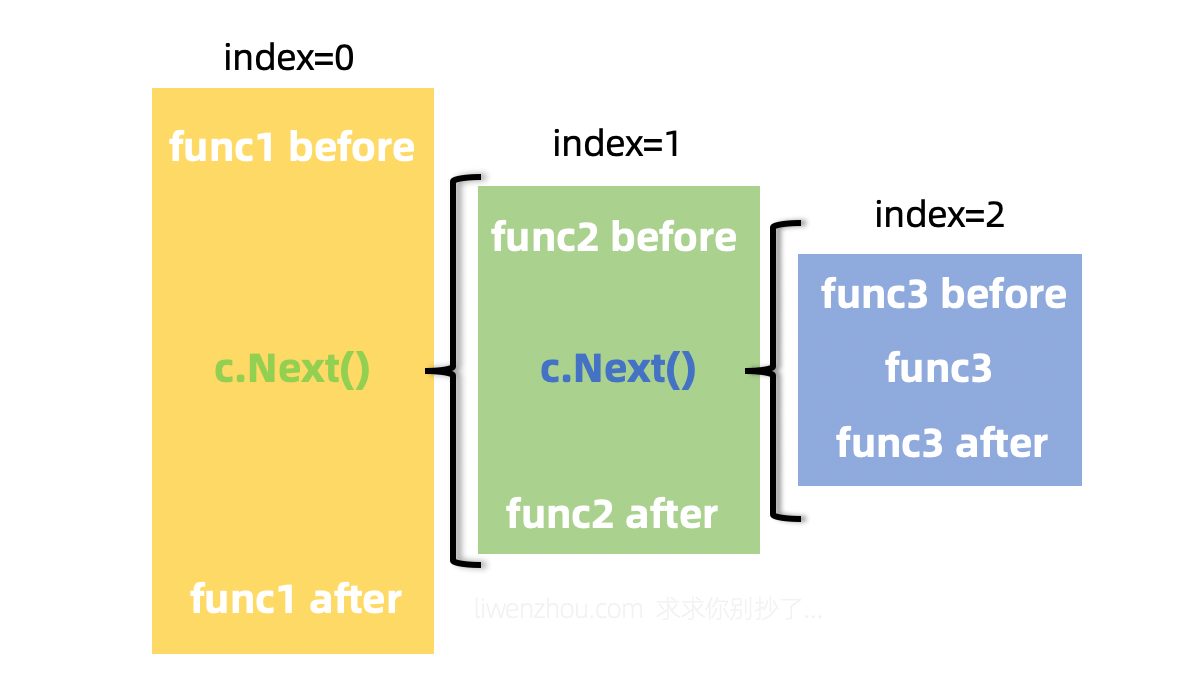

从上面的代码可以看到,这里通过索引遍历HandlersChain链条,从而实现依次调用该路由的每一个函数(中间件或处理请求的函数)。

我们可以在中间件函数中通过再次调用c.Next()实现嵌套调用(func1中调用func2;func2中调用func3),

或者通过调用c.Abort()中断整个调用链条,从当前函数返回。

1

2

3

|

func (c *Context) Abort() {

c.index = abortIndex // 直接将索引置为最大限制值,从而退出循环

}

|

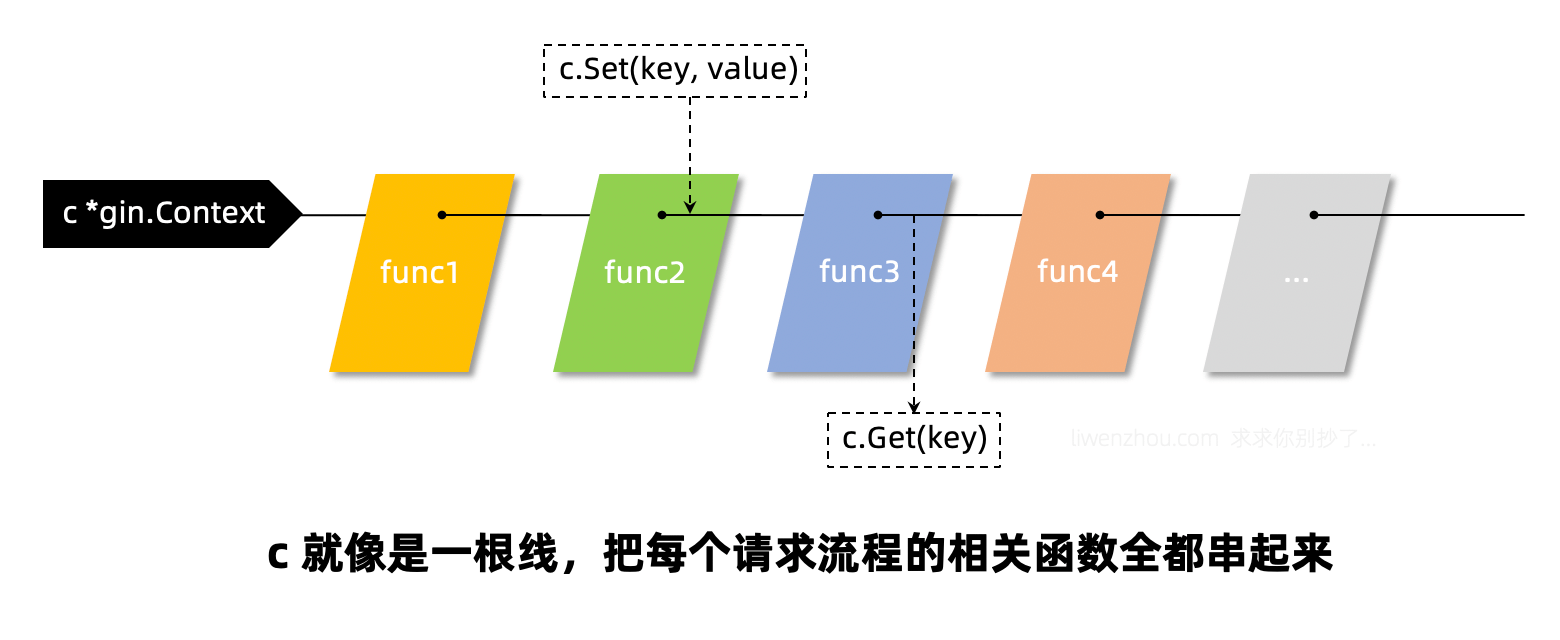

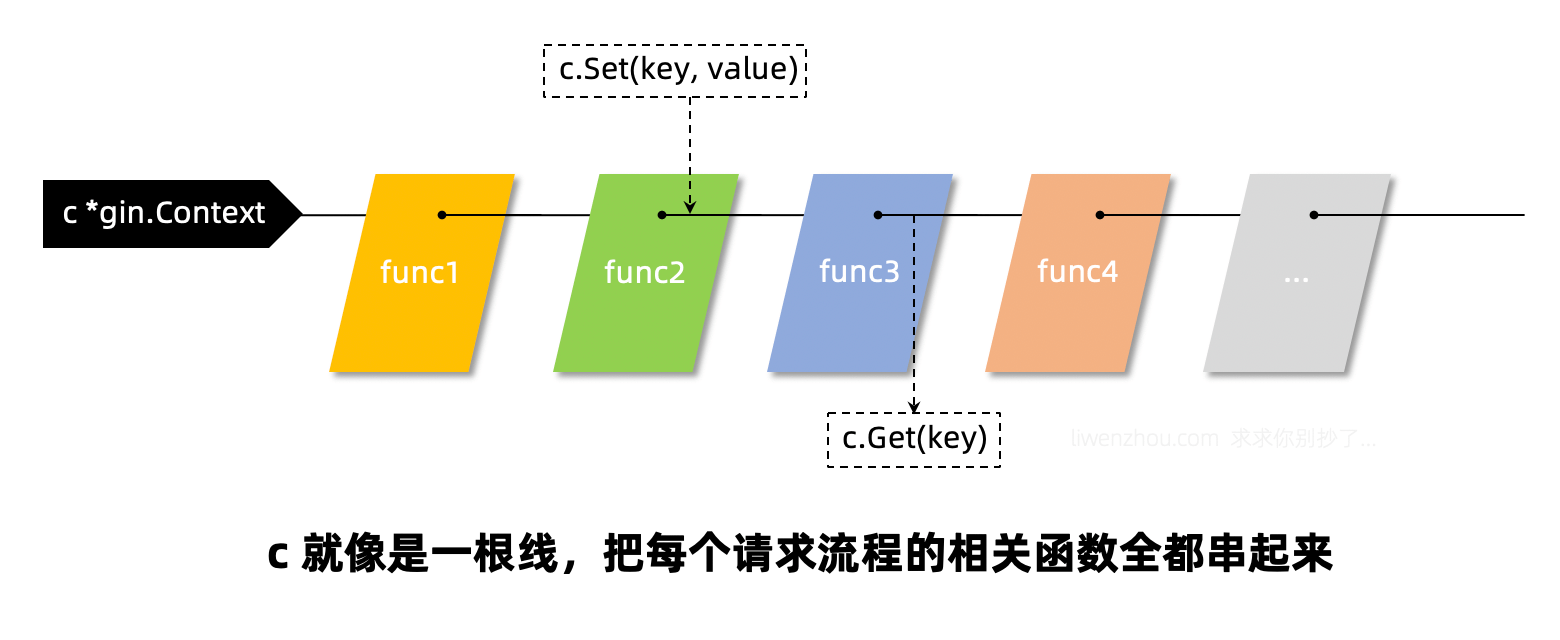

c.Set()/c.Get()

c.Set()和c.Get()这两个方法多用于在多个函数之间通过c传递数据的,比如我们可以在认证中间件中获取当前请求的相关信息(userID等)通过c.Set()存入c,然后在后续处理业务逻辑的函数中通过c.Get()来获取当前请求的用户。c就像是一根绳子,将该次请求相关的所有的函数都串起来了。

总结

- gin框架路由使用前缀树,路由注册的过程是构造前缀树的过程,路由匹配的过程就是查找前缀树的过程。

- gin框架的中间件函数和处理函数是以切片形式的调用链条存在的,我们可以顺序调用也可以借助

c.Next()方法实现嵌套调用。

- 借助

c.Set()和c.Get()方法我们能够在不同的中间件函数中传递数据。

Gin连接mysql

驱动依赖

go get -u github.com/go-sql-driver/mysql

如何使用

里面的user password可改

注意defer得卸载err的下面,不可以写成这样

为什么不能写在这个位置?

因为如果出错了,我们获得的open会是一个nil,在最后调用他的close,会出现空指针异常。

所以我们应该在判断当err == nil才去关闭数据库。

Open函数实际上只是验证dsn参数是否正确,并不是真正和数据库连接。如果要检查数据源的名字是否有效,应该调用ping方法。

当然一般不可能写在main函数里面,一般应该使模块化的操作。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

|

package main

import (

"database/sql"

"fmt"

_ "github.com/go-sql-driver/mysql"

)

var db *sql.DB

//这里用了一个匿名参数,我们可以不用在函数中声明err,但是会自己返回这个err参数。非常的优雅。

func initMysql() (err error) {

dsn := "root:abc123456@tcp(127.0.0.1:3306)/go"

db, err = sql.Open("mysql", dsn) //这里就不能用 := 因为db是公共变量

if err != nil {

panic(err)

}

err = db.Ping()

if err != nil {

fmt.Printf("connect fail , err : %v\n", err)

panic(err)

}

fmt.Printf("connect successful")

return

}

func main() {

if err := initMysql();err!=nil{

fmt.Printf("connect fail")

}

defer db.Close()

}

|

两个常用配置

SetMaxOpenCoons() 设置和mysql的最大连接数

SetMaxIdleCoons() 设置连接池的最大空闲连接数

浅浅的研究一下源码

看一看驱动里面的源码

init方法

点进去Regist

此时可以发现是跳到了内置的标准库database里面

在源码中,regist的是map中的值,比如map[“mysql”] = 驱动

看一看open函数里做了什么事情

可以发现我们是调用的openDB函数,返回的一个DB,有一些基本信息

我们的用户名,密码都在c里面

增删改查

queryRow(查询一列)

1

2

3

4

5

6

7

8

9

10

|

func queryRowDemo() {

sql := "select id,name,age from test_user where id = ?"

var u user

err := db.QueryRow(sql, 1).Scan(&u.id, &u.name, &u.age)

if err != nil {

fmt.Printf("scan failed , err : %v", err)

return

}

fmt.Printf("id: %v,name: %v,age: %v", u.id, u.name, u.age)

}

|

这边值得注意的是,在调用了queryRow之后一定要调用scan,不然不会释放连接。

query(查询多行)

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

|

func queryMultiRowDemo() {

sql := "select id,name,age from test_user where id > ? "

query, err := db.Query(sql, 0)

if err != nil {

fmt.Printf("query failed err: %v\n", err)

return

}

defer query.Close()//这里需要关闭

for query.Next() {

var u user

err = query.Scan(&u.id, &u.name, &u.age)

if err != nil {

fmt.Printf("scan failed err: %v\n", err)

return

}

fmt.Printf("id: %d,name: %s,age: %d\n", u.id, u.name, u.age)

}

}

|

为什么在中间需要close?不是在for中调用了scan,scan应该可以帮我们close嘛?因为不一定能够进去for循环。得手动调用close。

exec(插入和更新和删除)

插入

1

2

3

4

5

6

7

8

9

10

11

12

13

14

|

func insertRowDemo() {

sql := "insert into test_user(name,age)values(?,?)"

exec, err := db.Exec(sql, "peter", 99)

if err != nil {

fmt.Printf("insert failed err: %v\n", err)

return

}

id, err := exec.LastInsertId() //可以获得新插入的id

if err != nil {

fmt.Printf("get id failed err: %v\n", err)

return

}

fmt.Printf("insert success last id is %d \n", id)

}

|

更新

1

2

3

4

5

6

7

8

9

10

11

12

13

14

|

func updateRowDemo() {

sql := "update test_user set name = ? where id = ?"

exec, err := db.Exec(sql, "john", 3)

if err != nil {

fmt.Printf("update failed err: %v\n", err)

return

}

id, err := exec.RowsAffected() //可以影响的行数

if err != nil {

fmt.Printf("get row count failed err: %v\n", err)

return

}

fmt.Printf("update success row count is %d \n", id)

}

|

删除

1

2

3

4

5

6

7

8

9

10

11

12

13

14

|

func deleteRowDemo() {

sql := "delete from test_user where id = ?"

exec, err := db.Exec(sql, 3)

if err != nil {

fmt.Printf("delete failed err: %v\n", err)

return

}

id, err := exec.RowsAffected() //可以影响的行数

if err != nil {

fmt.Printf("get row count failed err: %v\n", err)

return

}

fmt.Printf("delete success row count is %d \n", id)

}

|

Mysql预处理与Sql注入

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

|

func prepareDemo() {

sql := "select id,name,age from test_user where id > ?"

prepare, err := db.Prepare(sql)

if err != nil {

fmt.Printf("prepare failed err: %v\n", err)

}

defer prepare.Close()

query, err := prepare.Query(0)

if err != nil {

fmt.Printf("query failed err: %v\n", err)

}

for query.Next() {

var u user

err = query.Scan(&u.id, &u.name, &u.age)

if err != nil {

fmt.Printf("scan failed err: %v\n", err)

}

fmt.Printf("id: %d,name: %s,age: %d\n", u.id, u.name, u.age)

}

}

|

sql注入

试试sql注入吧

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

|

func sqlInjection(name string) {

sql := fmt.Sprintf("select id,name,age from test_user where name = %s", name)

fmt.Println(sql)

query, err := db.Query(sql)

if err != nil {

fmt.Printf("scan failed err: %v\n", err)

return

}

for query.Next() {

var u user

err = query.Scan(&u.id, &u.name, &u.age)

if err != nil {

fmt.Printf("scan failed err: %v\n", err)

}

fmt.Printf("id: %d,name: %s,age: %d\n", u.id, u.name, u.age)

}

}

|

Mysql的事务

sqlX 强大的工具

安装

go get github.com/jmoiron/sqlx

连接

1

2

3

4

5

6

7

8

9

10

11

12

13

|

var db1 *sqlx.DB

func initDB() (err error) {

dsn := "root:abc123456@tcp(127.0.0.1:3306)/go"

db1, err = sqlx.Connect("mysql", dsn)

if err != nil {

fmt.Printf("err : %v\n", err)

return

}

db.SetMaxOpenConns(200)

db.SetMaxIdleConns(10)

return

}

|

SQLX的基本使用

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

|

type user1 struct {

Id int `db:"id"`

Name string `db:"name"`

Age int `db:"age"`

}

func queryRowDemo1() {

sql := "select id,name,age from test_user where id = ?"

var u user1

err := db1.Get(&u, sql, 1)

if err != nil {

fmt.Printf("get failed err: %v", err)

return

}

fmt.Printf("id: %v,name: %v,age: %v", u.Id, u.Name, u.Age)

}

|

注意结构体的值不可以写为小写,db1的get会通过反射给对象的属性赋值。如果为小写的话其他的包访问不到。

查询多个

1

2

3

4

5

6

7

8

9

10

11

|

func queryRowMultiDemo1() {

sql := "select id,name,age from test_user where id > ?"

var u []user1

err := db1.Select(&u, sql, 0)

if err != nil {

fmt.Printf("get failed err: %v", err)

return

}

fmt.Printf("users:%v", u)

}

|

增删改

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

|

// 插入数据

func insertRowDemo() {

sqlStr := "insert into user(name, age) values (?,?)"

ret, err := db.Exec(sqlStr, "沙河小王子", 19)

if err != nil {

fmt.Printf("insert failed, err:%v\n", err)

return

}

theID, err := ret.LastInsertId() // 新插入数据的id

if err != nil {

fmt.Printf("get lastinsert ID failed, err:%v\n", err)

return

}

fmt.Printf("insert success, the id is %d.\n", theID)

}

// 更新数据

func updateRowDemo() {

sqlStr := "update user set age=? where id = ?"

ret, err := db.Exec(sqlStr, 39, 6)

if err != nil {

fmt.Printf("update failed, err:%v\n", err)

return

}

n, err := ret.RowsAffected() // 操作影响的行数

if err != nil {

fmt.Printf("get RowsAffected failed, err:%v\n", err)

return

}

fmt.Printf("update success, affected rows:%d\n", n)

}

// 删除数据

func deleteRowDemo() {

sqlStr := "delete from user where id = ?"

ret, err := db.Exec(sqlStr, 6)

if err != nil {

fmt.Printf("delete failed, err:%v\n", err)

return

}

n, err := ret.RowsAffected() // 操作影响的行数

if err != nil {

fmt.Printf("get RowsAffected failed, err:%v\n", err)

return

}

fmt.Printf("delete success, affected rows:%d\n", n)

}

|

go-redis

1

|

go get -u github.com/go-redis/redis

|

连接redis

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

|

func initRedis() (err error) {

rdb = redis.NewClient(

&redis.Options{

Addr: "localhost:6379",

Password: "abc123456",

DB: 0,

PoolSize: 100, //连接池大小

})

_, err = rdb.Ping().Result()

if err != nil {

return err

}

return nil

}

func main() {

if err := initRedis(); err != nil {

fmt.Printf("err : %v", err)

return

}

fmt.Printf("connect success\n")

}

|

连接哨兵模式

基本使用

get/set

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

|

func redisDemo() {

err := rdb.Set("score", 100, 1).Err()

if err != nil {

fmt.Printf("set error err:%v\n", err)

}

result, err := rdb.Get("score").Result()

if err != nil {

fmt.Printf("get error err:%v\n", err)

return

}

fmt.Println(result)

s, err := rdb.Get("token").Result()

//优先判断错误是不是属于redis没有对应的key

if err == redis.Nil {

fmt.Printf("the key is not exist\n")

return

} else if err != nil {

fmt.Printf("err : %v", err)

return

} else {

fmt.Printf("%s\n", s)

}

}

|

hset,hmset,hget

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

|

func hgetDemo() (err error) {

rdb.HMSet("school", map[string]interface{}{

"name": "scuec",

"addr": "laofang",

"isLike": false,

})

err = rdb.HSet("user", "name", "phm").Err()

err = rdb.HSet("user", "age", "1").Err()

if err != nil {

fmt.Printf("err :%v\n", err)

return

}

//得到全部字段

result, err := rdb.HGetAll("user").Result()

if err == redis.Nil {

fmt.Printf("err: %v\n", err)

return err

} else if err != nil {

fmt.Printf("err: %v\n", err)

return err

} else {

fmt.Printf("result :%v\n", result)

}

val := rdb.HGet("user", "name").Val()

fmt.Printf("val :%v\n", val)

return

}

|

zset

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

|

func zSetDemo() {

key := "language_rank"

languages := []redis.Z{

redis.Z{Score: 100, Member: "Java"},

redis.Z{Score: 99, Member: "Golang"},

redis.Z{Score: 89, Member: "Python"},

redis.Z{Score: 80, Member: "C"},

redis.Z{Score: 0, Member: "C++"},

}

//language切片被打散一一add到zset中

result, err := rdb.ZAdd(key, languages...).Result()

if err != nil {

fmt.Printf("err :%v\n", err)

return

}

fmt.Printf("zadd %d success!", result)

//把Golang的分数+10

f, err := rdb.ZIncrBy(key, 10, "Golang").Result()

if err != nil {

fmt.Printf("err :%v\n", err)

return

}

fmt.Printf("new Score is %d\n", f)

//取最高的三个分数

zs, err := rdb.ZRevRangeWithScores(key, 0, 2).Result()

if err != nil {

fmt.Printf("err :%v\n", err)

return

}

for i, z := range zs {

fmt.Println(i, z.Member, z.Score)

}

//取90 - 100分的

ranges := redis.ZRangeBy{

Min: "90",

Max: "100",

}

strings, err := rdb.ZRevRangeByScoreWithScores(key, ranges).Result()

if err != nil {

fmt.Printf("err :%v\n", err)

return

}

if err != nil {

fmt.Printf("err :%v\n", err)

return

}

for i, z := range strings {

fmt.Println(i, z.Member, z.Score)

}

}

|

pipeline

事务

1

2

3

4

5

6

7

8

9

10

11

12

13

|

// 监视watch_count的值,并在值不变的前提下将其值+1

key := "watch_count"

err = client.Watch(func(tx *redis.Tx) error {

n, err := tx.Get(key).Int()

if err != nil && err != redis.Nil {

return err

}

_, err = tx.Pipelined(func(pipe redis.Pipeliner) error {

pipe.Set(key, n+1, 0)

return nil

})

return err

}, key)

|

Zap日志库

Gologger

Go logger的优劣?

Zap的优点

使用

获得

go get -u go.uber.org/zap

配置zap

Logger

- 通过调用

zap.NewProduction()/zap.NewDevelopment()或者zap.Example()创建一个Logger。

- 上面的每一个函数都将创建一个logger。唯一的区别在于它将记录的信息不同。例如production logger默认记录调用函数信息、日期和时间等。

- 通过Logger调用Info/Error等。

- 默认情况下日志都会打印到应用程序的console界面。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

|

package main

import (

"go.uber.org/zap"

"net/http"

)

var logger *zap.Logger

func main() {

InitLogg()

defer logger.Sync() //将logger的日志刷到磁盘

simpleHttp("www.google.com")

simpleHttp("http://www.google.com")

}

func InitLogg() {

logger, _ = zap.NewProduction()

}

func simpleHttp(url string) {

get, err := http.Get(url)

if err != nil {

logger.Error("Error fetching url..", zap.String("url", url), zap.Error(err))

} else {

logger.Info("success..", zap.String("statusCode", get.Status), zap.String("url", url))

get.Body.Close()

}

}

|

自定义配置项

将日志写入文件而不是终端

我们要做的第一个更改是把日志写入文件,而不是打印到应用程序控制台。

- 我们将使用

zap.New(…)方法来手动传递所有配置,而不是使用像zap.NewProduction()这样的预置方法来创建logger。

1

|

func New(core zapcore.Core, options ...Option) *Logger

|

zapcore.Core需要三个配置——Encoder,WriteSyncer,LogLevel。

1.Encoder:编码器(如何写入日志)。我们将使用开箱即用的NewJSONEncoder(),并使用预先设置的ProductionEncoderConfig()。

1

|

zapcore.NewJSONEncoder(zap.NewProductionEncoderConfig())

|

2.WriterSyncer :指定日志将写到哪里去。我们使用zapcore.AddSync()函数并且将打开的文件句柄传进去。

1

2

|

file, _ := os.Create("./logger.log")

writeSyncer := zapcore.AddSync(file)

|

3.Log Level:哪种级别的日志将被写入。

我们将修改上述部分中的Logger代码,并重写InitLogger()方法。其余方法—main() /SimpleHttpGet()保持不变。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

|

func InitLogg() {

writerSync := getLogWriter()

encoding := getEncoder()

core := zapcore.NewCore(encoding, writerSync, zapcore.DebugLevel)

logger = zap.New(core)

}

func getEncoder() zapcore.Encoder {

return zapcore.NewJSONEncoder(zap.NewProductionEncoderConfig())

}

func getLogWriter() zapcore.WriteSyncer {

f, _ := os.Create("./logger.log")

return zapcore.AddSync(f)

}

|

当使用这些修改过的logger配置调用上述部分的main()函数时,以下输出将打印在文件——test.log中。

1

2

3

4

|

{"level":"debug","ts":1572160754.994731,"msg":"Trying to hit GET request for www.sogo.com"}

{"level":"error","ts":1572160754.994982,"msg":"Error fetching URL www.sogo.com : Error = Get www.sogo.com: unsupported protocol scheme \"\""}

{"level":"debug","ts":1572160754.994996,"msg":"Trying to hit GET request for http://www.sogo.com"}

{"level":"info","ts":1572160757.3755069,"msg":"Success! statusCode = 200 OK for URL http://www.sogo.com"}

|

将JSON Encoder更改为普通的Log Encoder

现在,我们希望将编码器从JSON Encoder更改为普通Encoder。为此,我们需要将NewJSONEncoder()更改为NewConsoleEncoder()。

1

|

return zapcore.NewConsoleEncoder(zap.NewProductionEncoderConfig())

|

当使用这些修改过的logger配置调用上述部分的main()函数时,以下输出将打印在文件——test.log中。

1

2

3

4

|

1.572161051846623e+09 debug Trying to hit GET request for www.sogo.com

1.572161051846828e+09 error Error fetching URL www.sogo.com : Error = Get www.sogo.com: unsupported protocol scheme ""

1.5721610518468401e+09 debug Trying to hit GET request for http://www.sogo.com

1.572161052068744e+09 info Success! statusCode = 200 OK for URL http://www.sogo.com

|

更改时间编码并添加调用者详细信息

鉴于我们对配置所做的更改,有下面两个问题:

- 时间是以非人类可读的方式展示,例如1.572161051846623e+09

- 调用方函数的详细信息没有显示在日志中

我们要做的第一件事是覆盖默认的ProductionConfig(),并进行以下更改:

- 修改时间编码器

- 在日志文件中使用大写字母记录日志级别

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

|

func getEncoder() zapcore.Encoder {

return zapcore.NewConsoleEncoder(

zapcore.EncoderConfig{

TimeKey: "ts",

LevelKey: "level",

NameKey: "logger",

CallerKey: "caller",

FunctionKey: zapcore.OmitKey,

MessageKey: "msg",

StacktraceKey: "stacktrace",

LineEnding: zapcore.DefaultLineEnding,

EncodeLevel: zapcore.LowercaseLevelEncoder,

EncodeTime: zapcore.ISO8601TimeEncoder,

EncodeDuration: zapcore.SecondsDurationEncoder,

EncodeCaller: zapcore.ShortCallerEncoder,

})

}

|

接下来,我们将修改zap logger代码,添加将调用函数信息记录到日志中的功能。为此,我们将在zap.New(..)函数中添加一个Option。

1

|

logger := zap.New(core, zap.AddCaller())

|

当使用这些修改过的logger配置调用上述部分的main()函数时,以下输出将打印在文件——test.log中。

1

2

3

4

|

2019-10-27T15:33:29.855+0800 DEBUG logic/temp2.go:47 Trying to hit GET request for www.sogo.com

2019-10-27T15:33:29.855+0800 ERROR logic/temp2.go:50 Error fetching URL www.sogo.com : Error = Get www.sogo.com: unsupported protocol scheme ""

2019-10-27T15:33:29.856+0800 DEBUG logic/temp2.go:47 Trying to hit GET request for http://www.sogo.com

2019-10-27T15:33:30.125+0800 INFO logic/temp2.go:52 Success! statusCode = 200 OK for URL http://www.sogo.com

|

使用Lumberjack进行日志切割归档

这个日志程序中唯一缺少的就是日志切割归档功能。

Zap本身不支持切割归档日志文件

为了添加日志切割归档功能,我们将使用第三方库Lumberjack来实现。

安装

执行下面的命令安装Lumberjack

1

|

go get -u github.com/natefinch/lumberjack

|

zap logger中加入Lumberjack

要在zap中加入Lumberjack支持,我们需要修改WriteSyncer代码。我们将按照下面的代码修改getLogWriter()函数:

1

2

3

4

5

6

7

8

9

10

|

func getLogWriter() zapcore.WriteSyncer {

lumberJackLogger := &lumberjack.Logger{

Filename: "./test.log",

MaxSize: 10,

MaxBackups: 5,

MaxAge: 30,

Compress: false,

}

return zapcore.AddSync(lumberJackLogger)

}

|

Lumberjack Logger采用以下属性作为输入:

- Filename: 日志文件的位置

- MaxSize:在进行切割之前,日志文件的最大大小(以MB为单位)

- MaxBackups:保留旧文件的最大个数

- MaxAges:保留旧文件的最大天数

- Compress:是否压缩/归档旧文件

测试所有功能

最终,使用Zap/Lumberjack logger的完整示例代码如下:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

|

package main

import (

"net/http"

"github.com/natefinch/lumberjack"

"go.uber.org/zap"

"go.uber.org/zap/zapcore"

)

var sugarLogger *zap.SugaredLogger

func main() {

InitLogger()

defer sugarLogger.Sync()

simpleHttpGet("www.sogo.com")

simpleHttpGet("http://www.sogo.com")

}

func InitLogger() {

writeSyncer := getLogWriter()

encoder := getEncoder()

core := zapcore.NewCore(encoder, writeSyncer, zapcore.DebugLevel)

logger := zap.New(core, zap.AddCaller())

sugarLogger = logger.Sugar()

}

func getEncoder() zapcore.Encoder {

encoderConfig := zap.NewProductionEncoderConfig()

encoderConfig.EncodeTime = zapcore.ISO8601TimeEncoder

encoderConfig.EncodeLevel = zapcore.CapitalLevelEncoder

return zapcore.NewConsoleEncoder(encoderConfig)

}

func getLogWriter() zapcore.WriteSyncer {

lumberJackLogger := &lumberjack.Logger{

Filename: "./test.log",

MaxSize: 1,

MaxBackups: 5,

MaxAge: 30,

Compress: false,

}

return zapcore.AddSync(lumberJackLogger)

}

func simpleHttpGet(url string) {

sugarLogger.Debugf("Trying to hit GET request for %s", url)

resp, err := http.Get(url)

if err != nil {

sugarLogger.Errorf("Error fetching URL %s : Error = %s", url, err)

} else {

sugarLogger.Infof("Success! statusCode = %s for URL %s", resp.Status, url)

resp.Body.Close()

}

}

|

执行上述代码,下面的内容会输出到文件——test.log中。

1

2

3

4

|

2019-10-27T15:50:32.944+0800 DEBUG logic/temp2.go:48 Trying to hit GET request for www.sogo.com

2019-10-27T15:50:32.944+0800 ERROR logic/temp2.go:51 Error fetching URL www.sogo.com : Error = Get www.sogo.com: unsupported protocol scheme ""

2019-10-27T15:50:32.944+0800 DEBUG logic/temp2.go:48 Trying to hit GET request for http://www.sogo.com

2019-10-27T15:50:33.165+0800 INFO logic/temp2.go:53 Success! statusCode = 200 OK for URL http://www.sogo.com

|

同时,可以在main函数中循环记录日志,测试日志文件是否会自动切割和归档(日志文件每1MB会切割并且在当前目录下最多保存5个备份)。

至此,我们总结了如何将Zap日志程序集成到Go应用程序项目中。

gin整合zap

go get -u github.com/gin-gonic/gin

首先我们来看一个最简单的gin项目:

1

2

3

4

5

6

7

|

func main() {

r := gin.Default()

r.GET("/hello", func(c *gin.Context) {

c.String("hello liwenzhou.com!")

})

r.Run(

}

|

接下来我们看一下gin.Default()的源码:

1

2

3

4

5

6

|

func Default() *Engine {

debugPrintWARNINGDefault()

engine := New()

engine.Use(Logger(), Recovery())

return engine

}

|

也就是我们在使用gin.Default()的同时是用到了gin框架内的两个默认中间件Logger()和Recovery()。

其中Logger()是把gin框架本身的日志输出到标准输出(我们本地开发调试时在终端输出的那些日志就是它的功劳),而Recovery()是在程序出现panic的时候恢复现场并写入500响应的。

基于zap的中间件

我们可以模仿Logger()和Recovery()的实现,使用我们的日志库来接收gin框架默认输出的日志。

这里以zap为例,我们实现两个中间件如下:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

|

// GinLogger 接收gin框架默认的日志

func GinLogger(logger *zap.Logger) gin.HandlerFunc {

return func(c *gin.Context) {

start := time.Now()

path := c.Request.URL.Path

query := c.Request.URL.RawQuery

c.Next()

cost := time.Since(start)

logger.Info(path,

zap.Int("status", c.Writer.Status()),

zap.String("method", c.Request.Method),

zap.String("path", path),

zap.String("query", query),

zap.String("ip", c.ClientIP()),

zap.String("user-agent", c.Request.UserAgent()),

zap.String("errors", c.Errors.ByType(gin.ErrorTypePrivate).String()),

zap.Duration("cost", cost),

)

}

}

// GinRecovery recover掉项目可能出现的panic

func GinRecovery(logger *zap.Logger, stack bool) gin.HandlerFunc {

return func(c *gin.Context) {

defer func() {

if err := recover(); err != nil {

// Check for a broken connection, as it is not really a

// condition that warrants a panic stack trace.

var brokenPipe bool

if ne, ok := err.(*net.OpError); ok {

if se, ok := ne.Err.(*os.SyscallError); ok {

if strings.Contains(strings.ToLower(se.Error()), "broken pipe") || strings.Contains(strings.ToLower(se.Error()), "connection reset by peer") {

brokenPipe = true

}

}

}

httpRequest, _ := httputil.DumpRequest(c.Request, false)

if brokenPipe {

logger.Error(c.Request.URL.Path,

zap.Any("error", err),

zap.String("request", string(httpRequest)),

)

// If the connection is dead, we can't write a status to it.

c.Error(err.(error)) // nolint: errcheck

c.Abort()

return

}

if stack {

logger.Error("[Recovery from panic]",

zap.Any("error", err),

zap.String("request", string(httpRequest)),

zap.String("stack", string(debug.Stack())),

)

} else {

logger.Error("[Recovery from panic]",

zap.Any("error", err),

zap.String("request", string(httpRequest)),

)

}

c.AbortWithStatus(http.StatusInternalServerError)

}

}()

c.Next()

}

}

|

如果不想自己实现,可以使用github上有别人封装好的https://github.com/gin-contrib/zap。

这样我们就可以在gin框架中使用我们上面定义好的两个中间件来代替gin框架默认的Logger()和Recovery()了。

1

2

|

r := gin.New()

r.Use(GinLogger(), GinRecovery())

|

在gin项目中使用zap

最后我们再加入我们项目中常用的日志切割,完整版的logger.go代码如下:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

90

91

92

93

94

95

96

97

98

99

100

101

102

103

104

105

106

107

108

109

110

111

112

113

114

115

116

117

118

119

120

121

122

123

124

|

package logger

import (

"gin_zap_demo/config"

"net"

"net/http"

"net/http/httputil"

"os"

"runtime/debug"

"strings"

"time"

"github.com/gin-gonic/gin"

"github.com/natefinch/lumberjack"

"go.uber.org/zap"

"go.uber.org/zap/zapcore"

)

var lg *zap.Logger

// InitLogger 初始化Logger

func InitLogger(cfg *config.LogConfig) (err error) {

writeSyncer := getLogWriter(cfg.Filename, cfg.MaxSize, cfg.MaxBackups, cfg.MaxAge)

encoder := getEncoder()

var l = new(zapcore.Level)

err = l.UnmarshalText([]byte(cfg.Level))

if err != nil {

return

}

core := zapcore.NewCore(encoder, writeSyncer, l)

lg = zap.New(core, zap.AddCaller())

zap.ReplaceGlobals(lg) // 替换zap包中全局的logger实例,后续在其他包中只需使用zap.L()调用即可

return

}

func getEncoder() zapcore.Encoder {

encoderConfig := zap.NewProductionEncoderConfig()

encoderConfig.EncodeTime = zapcore.ISO8601TimeEncoder

encoderConfig.TimeKey = "time"

encoderConfig.EncodeLevel = zapcore.CapitalLevelEncoder

encoderConfig.EncodeDuration = zapcore.SecondsDurationEncoder

encoderConfig.EncodeCaller = zapcore.ShortCallerEncoder

return zapcore.NewJSONEncoder(encoderConfig)

}

func getLogWriter(filename string, maxSize, maxBackup, maxAge int) zapcore.WriteSyncer {

lumberJackLogger := &lumberjack.Logger{

Filename: filename,

MaxSize: maxSize,

MaxBackups: maxBackup,

MaxAge: maxAge,

}

return zapcore.AddSync(lumberJackLogger)

}

// GinLogger 接收gin框架默认的日志

func GinLogger() gin.HandlerFunc {

return func(c *gin.Context) {

start := time.Now()

path := c.Request.URL.Path

query := c.Request.URL.RawQuery

c.Next()

cost := time.Since(start)

lg.Info(path,

zap.Int("status", c.Writer.Status()),

zap.String("method", c.Request.Method),

zap.String("path", path),

zap.String("query", query),

zap.String("ip", c.ClientIP()),

zap.String("user-agent", c.Request.UserAgent()),

zap.String("errors", c.Errors.ByType(gin.ErrorTypePrivate).String()),

zap.Duration("cost", cost),

)

}

}

// GinRecovery recover掉项目可能出现的panic,并使用zap记录相关日志

func GinRecovery(stack bool) gin.HandlerFunc {

return func(c *gin.Context) {

defer func() {

if err := recover(); err != nil {

// Check for a broken connection, as it is not really a

// condition that warrants a panic stack trace.

var brokenPipe bool

if ne, ok := err.(*net.OpError); ok {

if se, ok := ne.Err.(*os.SyscallError); ok {

if strings.Contains(strings.ToLower(se.Error()), "broken pipe") || strings.Contains(strings.ToLower(se.Error()), "connection reset by peer") {

brokenPipe = true

}

}

}

httpRequest, _ := httputil.DumpRequest(c.Request, false)

if brokenPipe {

lg.Error(c.Request.URL.Path,

zap.Any("error", err),

zap.String("request", string(httpRequest)),

)

// If the connection is dead, we can't write a status to it.

c.Error(err.(error)) // nolint: errcheck

c.Abort()

return

}

if stack {

lg.Error("[Recovery from panic]",

zap.Any("error", err),

zap.String("request", string(httpRequest)),

zap.String("stack", string(debug.Stack())),

)

} else {

lg.Error("[Recovery from panic]",

zap.Any("error", err),

zap.String("request", string(httpRequest)),

)

}

c.AbortWithStatus(http.StatusInternalServerError)

}

}()

c.Next()

}

}

|

然后定义日志相关配置:

1

2

3

4

5

6

7

|

type LogConfig struct {

Level string `json:"level"`

Filename string `json:"filename"`

MaxSize int `json:"maxsize"`

MaxAge int `json:"max_age"`

MaxBackups int `json:"max_backups"`

}

|

在项目中先从配置文件加载配置信息,再调用logger.InitLogger(config.Conf.LogConfig)即可完成logger实例的初识化。其中,通过r.Use(logger.GinLogger(), logger.GinRecovery(true))注册我们的中间件来使用zap接收gin框架自身的日志,在项目中需要的地方通过使用zap.L().Xxx()方法来记录自定义日志信息。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

|

package main

import (

"fmt"

"gin_zap_demo/config"

"gin_zap_demo/logger"

"net/http"

"os"

"go.uber.org/zap"

"github.com/gin-gonic/gin"

)

func main() {

// load config from config.json

if len(os.Args) < 1 {

return

}

if err := config.Init(os.Args[1]); err != nil {

panic(err)

}

// init logger

if err := logger.InitLogger(config.Conf.LogConfig); err != nil {

fmt.Printf("init logger failed, err:%v\n", err)

return

}

gin.SetMode(config.Conf.Mode)

r := gin.Default()

// 注册zap相关中间件

r.Use(logger.GinLogger(), logger.GinRecovery(true))

r.GET("/hello", func(c *gin.Context) {

// 假设你有一些数据需要记录到日志中

var (

name = "q1mi"

age = 18

)

// 记录日志并使用zap.Xxx(key, val)记录相关字段

zap.L().Debug("this is hello func", zap.String("user", name), zap.Int("age", age))

c.String(http.StatusOK, "hello liwenzhou.com!")

})

addr := fmt.Sprintf(":%v", config.Conf.Port)

r.Run(addr)

}

|

Viper是适用于Go应用程序的完整配置解决方案。它被设计用于在应用程序中工作,并且可以处理所有类型的配置需求和格式。

Viper

Viper是适用于Go应用程序的完整配置解决方案。它被设计用于在应用程序中工作,并且可以处理所有类型的配置需求和格式。

鉴于viper库本身的README已经写得十分详细,这里就将其翻译成中文,并在最后附上两个项目中使用viper的示例代码以供参考。

安装

1

|

go get github.com/spf13/viper

|

什么是Viper?

Viper是适用于Go应用程序(包括Twelve-Factor App)的完整配置解决方案。它被设计用于在应用程序中工作,并且可以处理所有类型的配置需求和格式。它支持以下特性:

- 设置默认值

- 从

JSON、TOML、YAML、HCL、envfile和Java properties格式的配置文件读取配置信息

- 实时监控和重新读取配置文件(可选)

- 从环境变量中读取

- 从远程配置系统(etcd或Consul)读取并监控配置变化

- 从命令行参数读取配置

- 从buffer读取配置

- 显式配置值

为什么选择Viper?

在构建现代应用程序时,你无需担心配置文件格式;你想要专注于构建出色的软件。Viper的出现就是为了在这方面帮助你的。

Viper能够为你执行下列操作:

- 查找、加载和反序列化

JSON、TOML、YAML、HCL、INI、envfile和Java properties格式的配置文件。

- 提供一种机制为你的不同配置选项设置默认值。

- 提供一种机制来通过命令行参数覆盖指定选项的值。

- 提供别名系统,以便在不破坏现有代码的情况下轻松重命名参数。

- 当用户提供了与默认值相同的命令行或配置文件时,可以很容易地分辨出它们之间的区别。

Viper会按照下面的优先级。每个项目的优先级都高于它下面的项目:

- 显示调用

Set设置值

- 命令行参数(flag)

- 环境变量

- 配置文件

- key/value存储

- 默认值

重要: 目前Viper配置的键(Key)是大小写不敏感的。目前正在讨论是否将这一选项设为可选。

把值存入Viper

建立默认值

一个好的配置系统应该支持默认值。键不需要默认值,但如果没有通过配置文件、环境变量、远程配置或命令行标志(flag)设置键,则默认值非常有用。

例如:

1

2

3

|

viper.SetDefault("ContentDir", "content")

viper.SetDefault("LayoutDir", "layouts")

viper.SetDefault("Taxonomies", map[string]string{"tag": "tags", "category": "categories"})

|

读取配置文件

Viper需要最少知道在哪里查找配置文件的配置。Viper支持JSON、TOML、YAML、HCL、envfile和Java properties格式的配置文件。Viper可以搜索多个路径,但目前单个Viper实例只支持单个配置文件。Viper不默认任何配置搜索路径,将默认决策留给应用程序。

下面是一个如何使用Viper搜索和读取配置文件的示例。不需要任何特定的路径,但是至少应该提供一个配置文件预期出现的路径。

1

2

3

4

5

6

7

8

9

10

|

viper.SetConfigFile("./config.yaml") // 指定配置文件路径

viper.SetConfigName("config") // 配置文件名称(无扩展名)

viper.SetConfigType("yaml") // 如果配置文件的名称中没有扩展名,则需要配置此项

viper.AddConfigPath("/etc/appname/") // 查找配置文件所在的路径

viper.AddConfigPath("$HOME/.appname") // 多次调用以添加多个搜索路径

viper.AddConfigPath(".") // 还可以在工作目录中查找配置

err := viper.ReadInConfig() // 查找并读取配置文件

if err != nil { // 处理读取配置文件的错误

panic(fmt.Errorf("Fatal error config file: %s \n", err))

}

|

在加载配置文件出错时,你可以像下面这样处理找不到配置文件的特定情况:

1

2

3

4

5

6

7

8

9

|

if err := viper.ReadInConfig(); err != nil {

if _, ok := err.(viper.ConfigFileNotFoundError); ok {

// 配置文件未找到错误;如果需要可以忽略

} else {

// 配置文件被找到,但产生了另外的错误

}

}

// 配置文件找到并成功解析

|

注意[自1.6起]: 你也可以有不带扩展名的文件,并以编程方式指定其格式。对于位于用户$HOME目录中的配置文件没有任何扩展名,如.bashrc。

这里补充两个问题供读者解答并自行验证

当你使用如下方式读取配置时,viper会从./conf目录下查找任何以config为文件名的配置文件,如果同时存在./conf/config.json和./conf/config.yaml两个配置文件的话,viper会从哪个配置文件加载配置呢?

1

2

|

viper.SetConfigName("config")

viper.AddConfigPath("./conf")

|

在上面两个语句下搭配使用viper.SetConfigType("yaml")指定配置文件类型可以实现预期的效果吗?

写入配置文件

从配置文件中读取配置文件是有用的,但是有时你想要存储在运行时所做的所有修改。为此,可以使用下面一组命令,每个命令都有自己的用途:

- WriteConfig - 将当前的

viper配置写入预定义的路径并覆盖(如果存在的话)。如果没有预定义的路径,则报错。

- SafeWriteConfig - 将当前的

viper配置写入预定义的路径。如果没有预定义的路径,则报错。如果存在,将不会覆盖当前的配置文件。

- WriteConfigAs - 将当前的

viper配置写入给定的文件路径。将覆盖给定的文件(如果它存在的话)。

- SafeWriteConfigAs - 将当前的

viper配置写入给定的文件路径。不会覆盖给定的文件(如果它存在的话)。

根据经验,标记为safe的所有方法都不会覆盖任何文件,而是直接创建(如果不存在),而默认行为是创建或截断。

一个小示例:

1

2

3

4

5

|

viper.WriteConfig() // 将当前配置写入“viper.AddConfigPath()”和“viper.SetConfigName”设置的预定义路径

viper.SafeWriteConfig()

viper.WriteConfigAs("/path/to/my/.config")

viper.SafeWriteConfigAs("/path/to/my/.config") // 因为该配置文件写入过,所以会报错

viper.SafeWriteConfigAs("/path/to/my/.other_config")

|

监控并重新读取配置文件

Viper支持在运行时实时读取配置文件的功能。

需要重新启动服务器以使配置生效的日子已经一去不复返了,viper驱动的应用程序可以在运行时读取配置文件的更新,而不会错过任何消息。

只需告诉viper实例watchConfig。可选地,你可以为Viper提供一个回调函数,以便在每次发生更改时运行。

确保在调用WatchConfig()之前添加了所有的配置路径。

1

2

3

4

5

|

viper.WatchConfig()

viper.OnConfigChange(func(e fsnotify.Event) {

// 配置文件发生变更之后会调用的回调函数

fmt.Println("Config file changed:", e.Name)

})

|

从io.Reader读取配置

Viper预先定义了许多配置源,如文件、环境变量、标志和远程K/V存储,但你不受其约束。你还可以实现自己所需的配置源并将其提供给viper。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

|

viper.SetConfigType("yaml") // 或者 viper.SetConfigType("YAML")

// 任何需要将此配置添加到程序中的方法。

var yamlExample = []byte(`

Hacker: true

name: steve

hobbies:

- skateboarding

- snowboarding

- go

clothing:

jacket: leather

trousers: denim

age: 35

eyes : brown

beard: true

`)

viper.ReadConfig(bytes.NewBuffer(yamlExample))

viper.Get("name") // 这里会得到 "steve"

|

覆盖设置

这些可能来自命令行标志,也可能来自你自己的应用程序逻辑。

1

2

|

viper.Set("Verbose", true)

viper.Set("LogFile", LogFile)

|

注册和使用别名

别名允许多个键引用单个值

1

2

3

4

5

6

7

|

viper.RegisterAlias("loud", "Verbose") // 注册别名(此处loud和Verbose建立了别名)

viper.Set("verbose", true) // 结果与下一行相同

viper.Set("loud", true) // 结果与前一行相同

viper.GetBool("loud") // true

viper.GetBool("verbose") // true

|

使用环境变量

Viper完全支持环境变量。这使Twelve-Factor App开箱即用。有五种方法可以帮助与ENV协作:

AutomaticEnv()BindEnv(string...) : errorSetEnvPrefix(string)SetEnvKeyReplacer(string...) *strings.ReplacerAllowEmptyEnv(bool)

使用ENV变量时,务必要意识到Viper将ENV变量视为区分大小写。

Viper提供了一种机制来确保ENV变量是惟一的。通过使用SetEnvPrefix,你可以告诉Viper在读取环境变量时使用前缀。BindEnv和AutomaticEnv都将使用这个前缀。

BindEnv使用一个或两个参数。第一个参数是键名称,第二个是环境变量的名称。环境变量的名称区分大小写。如果没有提供ENV变量名,那么Viper将自动假设ENV变量与以下格式匹配:前缀+ “_” +键名全部大写。当你显式提供ENV变量名(第二个参数)时,它 不会 自动添加前缀。例如,如果第二个参数是“id”,Viper将查找环境变量“ID”。

在使用ENV变量时,需要注意的一件重要事情是,每次访问该值时都将读取它。Viper在调用BindEnv时不固定该值。

AutomaticEnv是一个强大的助手,尤其是与SetEnvPrefix结合使用时。调用时,Viper会在发出viper.Get请求时随时检查环境变量。它将应用以下规则。它将检查环境变量的名称是否与键匹配(如果设置了EnvPrefix)。

SetEnvKeyReplacer允许你使用strings.Replacer对象在一定程度上重写 Env 键。如果你希望在Get()调用中使用-或者其他什么符号,但是环境变量里使用_分隔符,那么这个功能是非常有用的。可以在viper_test.go中找到它的使用示例。

或者,你可以使用带有NewWithOptions工厂函数的EnvKeyReplacer。与SetEnvKeyReplacer不同,它接受StringReplacer接口,允许你编写自定义字符串替换逻辑。

默认情况下,空环境变量被认为是未设置的,并将返回到下一个配置源。若要将空环境变量视为已设置,请使用AllowEmptyEnv方法。

Env 示例:

1

2

3

4

5

6

|

SetEnvPrefix("spf") // 将自动转为大写

BindEnv("id")

os.Setenv("SPF_ID", "13") // 通常是在应用程序之外完成的

id := Get("id") // 13

|

使用Flags

Viper 具有绑定到标志的能力。具体来说,Viper支持Cobra库中使用的Pflag。

与BindEnv类似,该值不是在调用绑定方法时设置的,而是在访问该方法时设置的。这意味着你可以根据需要尽早进行绑定,即使在init()函数中也是如此。

对于单个标志,BindPFlag()方法提供此功能。

例如:

1

2

|

serverCmd.Flags().Int("port", 1138, "Port to run Application server on")

viper.BindPFlag("port", serverCmd.Flags().Lookup("port"))

|

你还可以绑定一组现有的pflags (pflag.FlagSet):

举个例子:

1

2

3

4

5

6

|

pflag.Int("flagname", 1234, "help message for flagname")

pflag.Parse()

viper.BindPFlags(pflag.CommandLine)

i := viper.GetInt("flagname") // 从viper而不是从pflag检索值

|

在 Viper 中使用 pflag 并不阻碍其他包中使用标准库中的 flag 包。pflag 包可以通过导入这些 flags 来处理flag包定义的flags。这是通过调用pflag包提供的便利函数AddGoFlagSet()来实现的。

例如:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

|

package main

import (

"flag"

"github.com/spf13/pflag"

)

func main() {

// 使用标准库 "flag" 包

flag.Int("flagname", 1234, "help message for flagname")

pflag.CommandLine.AddGoFlagSet(flag.CommandLine)

pflag.Parse()

viper.BindPFlags(pflag.CommandLine)

i := viper.GetInt("flagname") // 从 viper 检索值

...

}

|

flag接口

如果你不使用Pflag,Viper 提供了两个Go接口来绑定其他 flag 系统。

FlagValue表示单个flag。这是一个关于如何实现这个接口的非常简单的例子:

1

2

3

4

5

|

type myFlag struct {}

func (f myFlag) HasChanged() bool { return false }

func (f myFlag) Name() string { return "my-flag-name" }

func (f myFlag) ValueString() string { return "my-flag-value" }

func (f myFlag) ValueType() string { return "string" }

|

一旦你的 flag 实现了这个接口,你可以很方便地告诉Viper绑定它:

1

|

viper.BindFlagValue("my-flag-name", myFlag{})

|

FlagValueSet代表一组 flags 。这是一个关于如何实现这个接口的非常简单的例子:

1

2

3

4

5

6

7

8

9

|

type myFlagSet struct {

flags []myFlag

}

func (f myFlagSet) VisitAll(fn func(FlagValue)) {

for _, flag := range flags {

fn(flag)

}

}

|

一旦你的flag set实现了这个接口,你就可以很方便地告诉Viper绑定它:

1

2

3

4

|

fSet := myFlagSet{

flags: []myFlag{myFlag{}, myFlag{}},

}

viper.BindFlagValues("my-flags", fSet)

|

远程Key/Value存储支持

在Viper中启用远程支持,需要在代码中匿名导入viper/remote这个包。

1

|

import _ "github.com/spf13/viper/remote"

|

Viper将读取从Key/Value存储(例如etcd或Consul)中的路径检索到的配置字符串(如JSON、TOML、YAML、HCL、envfile和Java properties格式)。这些值的优先级高于默认值,但是会被从磁盘、flag或环境变量检索到的配置值覆盖。(译注:也就是说Viper加载配置值的优先级为:磁盘上的配置文件>命令行标志位>环境变量>远程Key/Value存储>默认值。)

Viper使用crypt从K/V存储中检索配置,这意味着如果你有正确的gpg密匙,你可以将配置值加密存储并自动解密。加密是可选的。

你可以将远程配置与本地配置结合使用,也可以独立使用。

crypt有一个命令行助手,你可以使用它将配置放入K/V存储中。crypt默认使用在http://127.0.0.1:4001的etcd。

1

2

|

$ go get github.com/bketelsen/crypt/bin/crypt

$ crypt set -plaintext /config/hugo.json /Users/hugo/settings/config.json

|

确认值已经设置:

1

|

$ crypt get -plaintext /config/hugo.json

|

有关如何设置加密值或如何使用Consul的示例,请参见crypt文档。

远程Key/Value存储示例-未加密

etcd

1

2

3

|

viper.AddRemoteProvider("etcd", "http://127.0.0.1:4001","/config/hugo.json")

viper.SetConfigType("json") // 因为在字节流中没有文件扩展名,所以这里需要设置下类型。支持的扩展名有 "json", "toml", "yaml", "yml", "properties", "props", "prop", "env", "dotenv"

err := viper.ReadRemoteConfig()

|

Consul

你需要 Consul Key/Value存储中设置一个Key保存包含所需配置的JSON值。例如,创建一个keyMY_CONSUL_KEY将下面的值存入Consul key/value 存储:

1

2

3

4

5

6

7

8

9

10

|

{

"port": 8080,

"hostname": "liwenzhou.com"

}

viper.AddRemoteProvider("consul", "localhost:8500", "MY_CONSUL_KEY")

viper.SetConfigType("json") // 需要显示设置成json

err := viper.ReadRemoteConfig()

fmt.Println(viper.Get("port")) // 8080

fmt.Println(viper.Get("hostname")) // liwenzhou.com

|

Firestore

1

2

3

|

viper.AddRemoteProvider("firestore", "google-cloud-project-id", "collection/document")

viper.SetConfigType("json") // 配置的格式: "json", "toml", "yaml", "yml"

err := viper.ReadRemoteConfig()

|

当然,你也可以使用SecureRemoteProvider。

远程Key/Value存储示例-加密

1

2

3

|

viper.AddSecureRemoteProvider("etcd","http://127.0.0.1:4001","/config/hugo.json","/etc/secrets/mykeyring.gpg")

viper.SetConfigType("json") // 因为在字节流中没有文件扩展名,所以这里需要设置下类型。支持的扩展名有 "json", "toml", "yaml", "yml", "properties", "props", "prop", "env", "dotenv"

err := viper.ReadRemoteConfig()

|

监控etcd中的更改-未加密

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

|

// 或者你可以创建一个新的viper实例

var runtime_viper = viper.New()

runtime_viper.AddRemoteProvider("etcd", "http://127.0.0.1:4001", "/config/hugo.yml")

runtime_viper.SetConfigType("yaml") // 因为在字节流中没有文件扩展名,所以这里需要设置下类型。支持的扩展名有 "json", "toml", "yaml", "yml", "properties", "props", "prop", "env", "dotenv"

// 第一次从远程读取配置

err := runtime_viper.ReadRemoteConfig()

// 反序列化

runtime_viper.Unmarshal(&runtime_conf)

// 开启一个单独的goroutine一直监控远端的变更

go func(){

for {

time.Sleep(time.Second * 5) // 每次请求后延迟一下

// 目前只测试了etcd支持

err := runtime_viper.WatchRemoteConfig()

if err != nil {

log.Errorf("unable to read remote config: %v", err)

continue

}

// 将新配置反序列化到我们运行时的配置结构体中。你还可以借助channel实现一个通知系统更改的信号

runtime_viper.Unmarshal(&runtime_conf)

}

}()

|

从Viper获取值

在Viper中,有几种方法可以根据值的类型获取值。存在以下功能和方法:

Get(key string) : interface{}GetBool(key string) : boolGetFloat64(key string) : float64GetInt(key string) : intGetIntSlice(key string) : []intGetString(key string) : stringGetStringMap(key string) : map[string]interface{}GetStringMapString(key string) : map[string]stringGetStringSlice(key string) : []stringGetTime(key string) : time.TimeGetDuration(key string) : time.DurationIsSet(key string) : boolAllSettings() : map[string]interface{}

需要认识到的一件重要事情是,每一个Get方法在找不到值的时候都会返回零值。为了检查给定的键是否存在,提供了IsSet()方法。

例如:

1

2

3

4

|

viper.GetString("logfile") // 不区分大小写的设置和获取

if viper.GetBool("verbose") {

fmt.Println("verbose enabled")

}

|

访问嵌套的键

访问器方法也接受深度嵌套键的格式化路径。例如,如果加载下面的JSON文件:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

|

{

"host": {

"address": "localhost",

"port": 5799

},

"datastore": {

"metric": {

"host": "127.0.0.1",

"port": 3099

},

"warehouse": {

"host": "198.0.0.1",

"port": 2112

}

}

}

|

Viper可以通过传入.分隔的路径来访问嵌套字段:

1

|

GetString("datastore.metric.host") // (返回 "127.0.0.1")

|

这遵守上面建立的优先规则;搜索路径将遍历其余配置注册表,直到找到为止。(译注:因为Viper支持从多种配置来源,例如磁盘上的配置文件>命令行标志位>环境变量>远程Key/Value存储>默认值,我们在查找一个配置的时候如果在当前配置源中没找到,就会继续从后续的配置源查找,直到找到为止。)

例如,在给定此配置文件的情况下,datastore.metric.host和datastore.metric.port均已定义(并且可以被覆盖)。如果另外在默认值中定义了datastore.metric.protocol,Viper也会找到它。

然而,如果datastore.metric被直接赋值覆盖(被flag,环境变量,set()方法等等…),那么datastore.metric的所有子键都将变为未定义状态,它们被高优先级配置级别“遮蔽”(shadowed)了。

最后,如果存在与分隔的键路径匹配的键,则返回其值。例如:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

|

{

"datastore.metric.host": "0.0.0.0",

"host": {

"address": "localhost",

"port": 5799

},

"datastore": {

"metric": {

"host": "127.0.0.1",

"port": 3099

},

"warehouse": {

"host": "198.0.0.1",

"port": 2112

}

}

}

GetString("datastore.metric.host") // 返回 "0.0.0.0"

|

提取子树

从Viper中提取子树。

例如,viper实例现在代表了以下配置:

1

2

3

4

5

6

7

|

app:

cache1:

max-items: 100

item-size: 64

cache2:

max-items: 200

item-size: 80

|

执行后:

1

|

subv := viper.Sub("app.cache1")

|

subv现在就代表:

1

2

|

max-items: 100

item-size: 64

|

假设我们现在有这么一个函数:

1

|

func NewCache(cfg *Viper) *Cache {...}

|

它基于subv格式的配置信息创建缓存。现在,可以轻松地分别创建这两个缓存,如下所示:

1

2

3

4

5

|

cfg1 := viper.Sub("app.cache1")

cache1 := NewCache(cfg1)

cfg2 := viper.Sub("app.cache2")

cache2 := NewCache(cfg2)

|

反序列化

你还可以选择将所有或特定的值解析到结构体、map等。

有两种方法可以做到这一点:

Unmarshal(rawVal interface{}) : errorUnmarshalKey(key string, rawVal interface{}) : error

举个例子:

1

2

3

4

5

6

7

8

9

10

11

12

|

type config struct {

Port int

Name string

PathMap string `mapstructure:"path_map"`

}

var C config

err := viper.Unmarshal(&C)

if err != nil {

t.Fatalf("unable to decode into struct, %v", err)

}

|

如果你想要解析那些键本身就包含.(默认的键分隔符)的配置,你需要修改分隔符:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

|

v := viper.NewWithOptions(viper.KeyDelimiter("::"))

v.SetDefault("chart::values", map[string]interface{}{

"ingress": map[string]interface{}{

"annotations": map[string]interface{}{

"traefik.frontend.rule.type": "PathPrefix",

"traefik.ingress.kubernetes.io/ssl-redirect": "true",

},

},

})

type config struct {

Chart struct{

Values map[string]interface{}

}

}

var C config

v.Unmarshal(&C)

|

Viper还支持解析到嵌入的结构体:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

|

/*

Example config:

module:

enabled: true

token: 89h3f98hbwf987h3f98wenf89ehf

*/

type config struct {

Module struct {

Enabled bool

moduleConfig `mapstructure:",squash"`

}

}

// moduleConfig could be in a module specific package

type moduleConfig struct {

Token string

}

var C config

err := viper.Unmarshal(&C)

if err != nil {

t.Fatalf("unable to decode into struct, %v", err)

}

|

Viper在后台使用github.com/mitchellh/mapstructure来解析值,其默认情况下使用mapstructuretag。